个人成就

-

一种异系统邻区选择方法、装置专利发明者

-

领域专家: 算法与数据结构技术领域

-

获得8,161次点赞

-

内容获得826次评论

-

获得14,106次收藏

-

代码片获得10,624次分享

-

TA的专栏

-

白话机器学习 付费167篇

白话机器学习 付费167篇 -

100天玩转python语言 付费78篇

100天玩转python语言 付费78篇 -

数据结构算法 付费82篇

数据结构算法 付费82篇 -

算法面试精选汇编 111篇

算法面试精选汇编 111篇 -

大模型 43篇

大模型 43篇 -

计算机课程毕设源码 196篇

计算机课程毕设源码 196篇 -

毕业设计 182篇

毕业设计 182篇 -

javascript简易教程 142篇

javascript简易教程 142篇 -

算法与数据结构面试宝典 93篇

算法与数据结构面试宝典 93篇 -

pyhton数据分析及可视化-从入门到实践 12篇

pyhton数据分析及可视化-从入门到实践 12篇 -

Python Flask 11篇

Python Flask 11篇 -

PythonFlask 9篇

PythonFlask 9篇 -

Linux源码剖析 75篇

Linux源码剖析 75篇 -

Go语言面试宝典 28篇

Go语言面试宝典 28篇 -

深度学习 8篇

深度学习 8篇 -

c++ 45篇

c++ 45篇 -

c++面试宝典 50篇

c++面试宝典 50篇 -

MFC 17篇

MFC 17篇 -

windows 25篇

windows 25篇 -

孙鑫VC++学习笔记 11篇

孙鑫VC++学习笔记 11篇 -

Win32 12篇

Win32 12篇 -

PE结构 11篇

PE结构 11篇 -

More Effective C++ 17篇

More Effective C++ 17篇 -

Effective STL 4篇

Effective STL 4篇 -

安全 12篇

安全 12篇 -

Visual Studio 3篇

Visual Studio 3篇 -

模板与泛型编程 2篇

模板与泛型编程 2篇 -

javascript 78篇

javascript 78篇

TA关注的专栏 3

TA关注的收藏夹 0

TA关注的社区 13

TA参与的活动 5

TA的推广

#玩转CSDN付费资源项目#

详细介绍了如何提升原力等级,如何批量自动化运营CSDN的付费资源项目,助力获取被动收益。详情参见我的文章 https://zhuyuan11.blog.csdn.net/article/details/131864213

创作活动更多

AI 镜像开发实战征文活动

随着人工智能技术的飞速发展,AI 镜像开发逐渐成为技术领域的热点之一。Stable Diffusion 3.5 FP8 作为强大的文生图模型,为开发者提供了更高效的图像生成解决方案。为了推动 AI 镜像开发技术的交流与创新,我们特此发起本次征文活动,诚邀广大开发者分享在 Stable Diffusion 3.5 FP8 文生图方向的实战经验和创新应用 本次征文活动鼓励开发者围绕 Stable Diffusion 3.5 FP8 文生图方向,分享以下方面的内容: 1. 技术实践与优化 - Stable Diffusion 3.5 FP8 模型架构解析与优化技巧 - 文生图生成效果的提升方法与技巧 - 模型部署与加速策略,例如使用 Hugging Face、Diffusers 等工具 - 针对特定场景(例如二次元、写实风)的模型微调与定制化开发 2. 应用场景探索 - Stable Diffusion 3.5 FP8 在不同领域的应用案例分享,例如游戏设计、广告创意、艺术创作等 - 利用 Stable Diffusion 3.5 FP8 实现图像编辑、图像修复、图像增强等功能的探索 - 结合其他 AI 技术(例如 NLP、语音识别)构建更强大的应用 3. 创新应用与思考 - 基于 Stable Diffusion 3.5 FP8 的创新应用场景设计 - AI 镜像开发的未来发展方向的思考与展望 - 对 AI 镜像开发伦理、安全等问题的探讨

32人参与 去参加

- 最近

- 文章

- 专栏

- 代码仓

- 资源

- 收藏

- 关注/订阅/互动

更多

最近

文章

专栏

代码仓

资源

收藏

关注/订阅/互动

社区

帖子

问答

课程

视频

搜索 取消

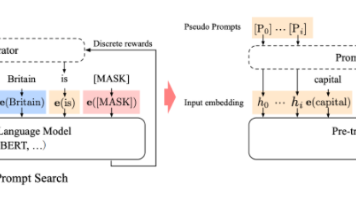

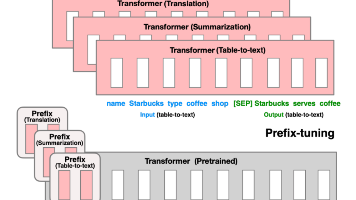

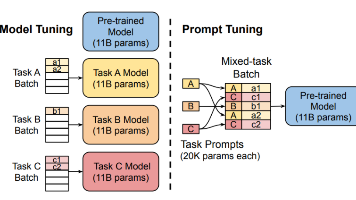

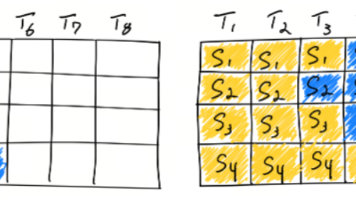

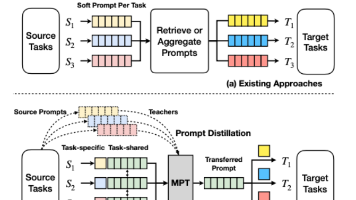

摘要:2023年5月提出的多任务提示调整(MPT)方法通过两阶段学习实现跨任务提示共享。第一阶段通过多任务训练提炼通用提示矩阵,第二阶段通过Hadamard积将通用提示与任务特定低秩矩阵结合来适应新任务。该方法可类比为学生先掌握通用解题技巧,再根据具体学科特点进行针对性复习。相比为每个任务单独学习提示的传统方法,MPT实现了提示参数的高效共享与适配。