个人简介:CSDN大数据领域博客专家,InfoQ写作社区2022年度影响力作者、华为云社区2022年度十佳博主、华为云享专家、阿里云专家博主、腾讯云开发者社区2022年度最佳作者、腾云先锋(TDP)核心成员、51CTO专家博主,全网二十万多粉丝,知名互联网公司大数据高级开发工程师

Lansonli(蓝深李)的博客

-

2022年度博客之星大数据领域TOP 2

-

领域专家: 大数据技术领域

-

获得21,058次点赞

-

内容获得19,307次评论

-

获得23,700次收藏

-

代码片获得6,884次分享

-

-

大数据入门核心技术 付费314篇

大数据入门核心技术 付费314篇 -

大数据OLAP技术体系 付费154篇

大数据OLAP技术体系 付费154篇 -

数据湖基础+湖仓一体电商项目 付费45篇

数据湖基础+湖仓一体电商项目 付费45篇 -

客快物流大数据项目 付费119篇

客快物流大数据项目 付费119篇 -

大数据必学Java基础 付费124篇

大数据必学Java基础 付费124篇 -

Spring系列核心知识 付费41篇

Spring系列核心知识 付费41篇 -

Python零基础入门 付费26篇

Python零基础入门 付费26篇 -

大数据进阶知识 付费16篇

大数据进阶知识 付费16篇 -

云原生核心技术 付费46篇

云原生核心技术 付费46篇 -

大数据必学语言Scala 付费39篇

大数据必学语言Scala 付费39篇 -

大数据其他相关技术原理 付费38篇

大数据其他相关技术原理 付费38篇 -

PostgreSQL 15篇

PostgreSQL 15篇 -

量子计算 22篇

量子计算 22篇 -

云原生 66篇

云原生 66篇 -

程序人生 12篇

程序人生 12篇 -

编程小技巧 1篇

编程小技巧 1篇 -

大数据 65篇

大数据 65篇 -

Apache Druid 8篇

Apache Druid 8篇 -

数据中台 11篇

数据中台 11篇 -

Hive 15篇

Hive 15篇 -

ELK 35篇

ELK 35篇 -

Kafka 12篇

Kafka 12篇 -

HBase 19篇

HBase 19篇 -

Hadoop 30篇

Hadoop 30篇 -

ZooKeeper 6篇

ZooKeeper 6篇 -

Flink 122篇

Flink 122篇 -

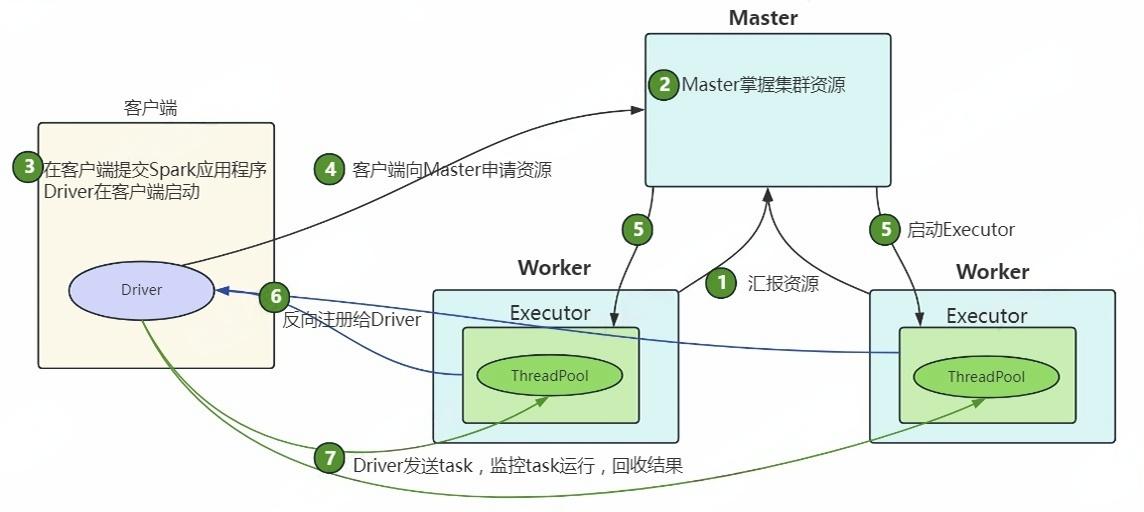

Spark 82篇

Spark 82篇 -

Linux 41篇

Linux 41篇 -

API/RPC/Socket技术 20篇

API/RPC/Socket技术 20篇 -

Java 11篇

Java 11篇 -

人工智能 18篇

人工智能 18篇 -

数据结构与算法 5篇

数据结构与算法 5篇 -

商品名词解释与逻辑设计 7篇

商品名词解释与逻辑设计 7篇 -

MySQL 31篇

MySQL 31篇 -

PHP 43篇

PHP 43篇 -

代码管理工具(Git/Svn) 13篇

代码管理工具(Git/Svn) 13篇 -

JavaScript HTML/CSS/前端知识体系 3篇

JavaScript HTML/CSS/前端知识体系 3篇 -

黑客 4篇

黑客 4篇 -

Python(爬虫/网站/人工智能) 83篇

Python(爬虫/网站/人工智能) 83篇 -

Docker 15篇

Docker 15篇 -

MQ/非关系数据库/分布式 25篇

MQ/非关系数据库/分布式 25篇 -

CentOS 22篇

CentOS 22篇

TA关注的专栏 29

TA关注的收藏夹 0

TA关注的社区 415

TA参与的活动 16

AI 镜像开发实战征文活动

随着人工智能技术的飞速发展,AI 镜像开发逐渐成为技术领域的热点之一。Stable Diffusion 3.5 FP8 作为强大的文生图模型,为开发者提供了更高效的图像生成解决方案。为了推动 AI 镜像开发技术的交流与创新,我们特此发起本次征文活动,诚邀广大开发者分享在 Stable Diffusion 3.5 FP8 文生图方向的实战经验和创新应用 本次征文活动鼓励开发者围绕 Stable Diffusion 3.5 FP8 文生图方向,分享以下方面的内容: 1. 技术实践与优化 - Stable Diffusion 3.5 FP8 模型架构解析与优化技巧 - 文生图生成效果的提升方法与技巧 - 模型部署与加速策略,例如使用 Hugging Face、Diffusers 等工具 - 针对特定场景(例如二次元、写实风)的模型微调与定制化开发 2. 应用场景探索 - Stable Diffusion 3.5 FP8 在不同领域的应用案例分享,例如游戏设计、广告创意、艺术创作等 - 利用 Stable Diffusion 3.5 FP8 实现图像编辑、图像修复、图像增强等功能的探索 - 结合其他 AI 技术(例如 NLP、语音识别)构建更强大的应用 3. 创新应用与思考 - 基于 Stable Diffusion 3.5 FP8 的创新应用场景设计 - AI 镜像开发的未来发展方向的思考与展望 - 对 AI 镜像开发伦理、安全等问题的探讨

- 最近

- 文章

- 专栏

- 资源

- 代码仓

- 帖子

- 关注/订阅/互动

最近

文章

专栏

资源

代码仓

帖子

关注/订阅/互动

社区