-

开启大模型时代的ChatGPT系列:包含原理、RLHF等 8篇

开启大模型时代的ChatGPT系列:包含原理、RLHF等 8篇 -

LLaMA/Gemma/Mistral:国外的开源LLM 6篇

LLaMA/Gemma/Mistral:国外的开源LLM 6篇 -

火爆全球的DeepSeek系列模型 13篇

火爆全球的DeepSeek系列模型 13篇 -

国产Qwen与GLM LLM系列:含最新Qwen3 4篇

国产Qwen与GLM LLM系列:含最新Qwen3 4篇 -

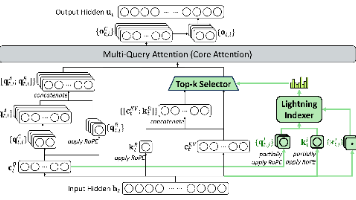

大模型背后的关键技术:LoRA/并行训练等 8篇

大模型背后的关键技术:LoRA/并行训练等 8篇 -

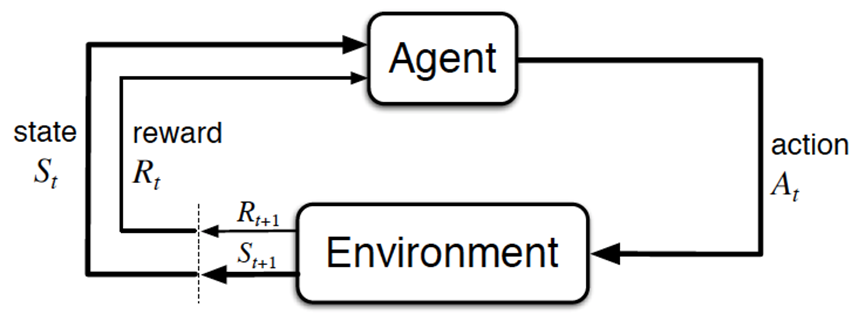

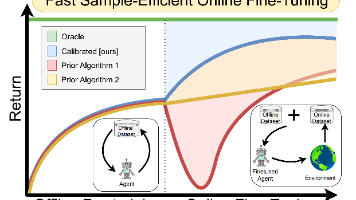

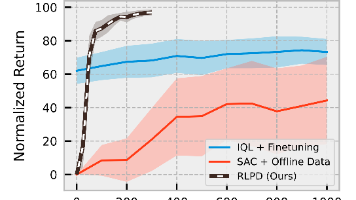

强化学习系列:包含PPO DPO GRPO GSPO 5篇

强化学习系列:包含PPO DPO GRPO GSPO 5篇 -

改进与挑战Transformer:mamba/TTT等 7篇

改进与挑战Transformer:mamba/TTT等 7篇 -

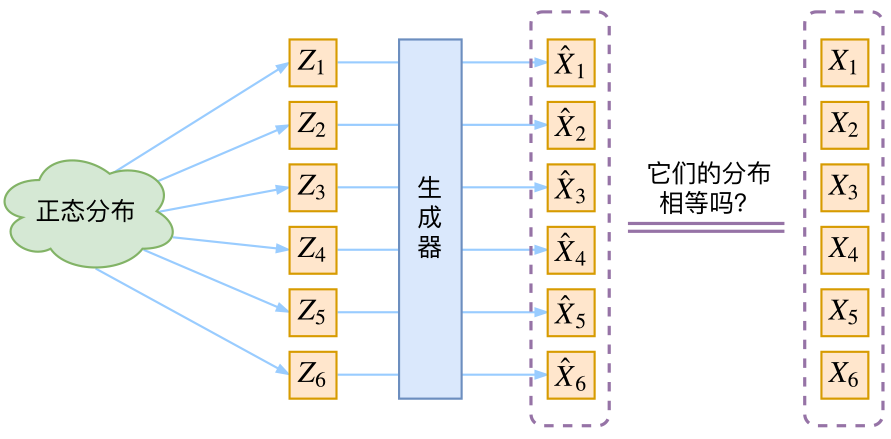

扩散去噪DDPM与AIGC发展史:图像/视频/代码的生成 11篇

扩散去噪DDPM与AIGC发展史:图像/视频/代码的生成 11篇 -

多模态:ViT CLIP到Qwen-VL PaliGemma 6篇

多模态:ViT CLIP到Qwen-VL PaliGemma 6篇 -

检测与分割史:从专用DETR、SAM2到通用DINOv3 5篇

检测与分割史:从专用DETR、SAM2到通用DINOv3 5篇 -

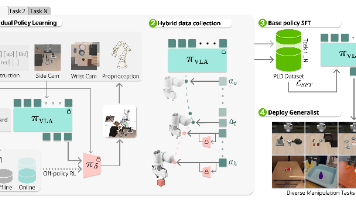

ALOHA ACT系列:mobile aloha为代表的IL 11篇

ALOHA ACT系列:mobile aloha为代表的IL 11篇 -

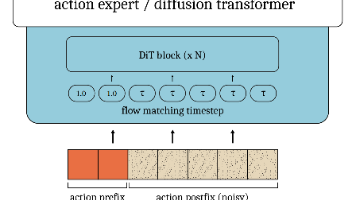

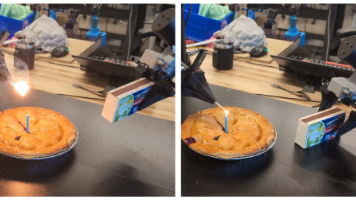

Diffusion Policy系列:umi与dexcap 8篇

Diffusion Policy系列:umi与dexcap 8篇 -

LeRobot系列:封装了ACT/DP/π0等 6篇

LeRobot系列:封装了ACT/DP/π0等 6篇 -

VLM规划下加约束:SayCan、ReKep等 5篇

VLM规划下加约束:SayCan、ReKep等 5篇 -

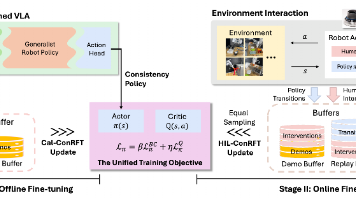

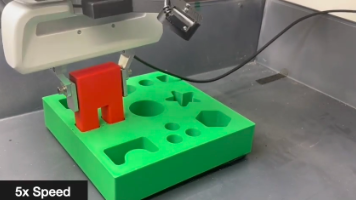

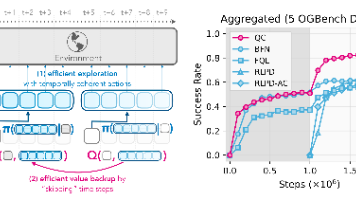

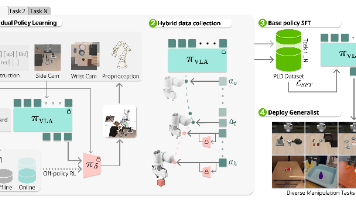

精密插拔与装配:从RL、VLA(含力/触)到RL微调VLA 20篇

精密插拔与装配:从RL、VLA(含力/触)到RL微调VLA 20篇 -

机械臂VLA发展史:RT2/OpenVLA/3D VLA 17篇

机械臂VLA发展史:RT2/OpenVLA/3D VLA 17篇 -

VLA风向标之π0系列(含π0.5和π0.6):复现/微调 12篇

VLA风向标之π0系列(含π0.5和π0.6):复现/微调 12篇 -

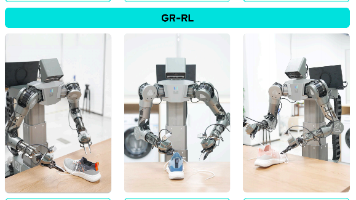

人形manipulation:iDP3/GR00T/Tele 13篇

人形manipulation:iDP3/GR00T/Tele 13篇 -

人形locomotion:Exbody/H2O/ASAP 23篇

人形locomotion:Exbody/H2O/ASAP 23篇 -

人形loco-mani:PhysHSI/TWIST2等 19篇

人形loco-mani:PhysHSI/TWIST2等 19篇 -

以VLN为代表的人形导航:包含NaVILA、NaVid等 11篇

以VLN为代表的人形导航:包含NaVILA、NaVid等 11篇 -

七月科研论文大模型:含论文的审稿微调、阅读、写作、修订 16篇

七月科研论文大模型:含论文的审稿微调、阅读、写作、修订 16篇 -

RAG企业知识库问答系列 5篇

RAG企业知识库问答系列 5篇 -

AI Agent:包含各种智能体,比如让AI按步骤生成论文 2篇

AI Agent:包含各种智能体,比如让AI按步骤生成论文 2篇 -

我的创业与读书史:从教育、大模型开发到具身开发 11篇

我的创业与读书史:从教育、大模型开发到具身开发 11篇 -

机器学习十大算法系列 29篇

机器学习十大算法系列 29篇 -

微软面试100题系列 36篇

微软面试100题系列 36篇 -

程序员编程艺术 35篇

程序员编程艺术 35篇 -

BAT AI面试1000题系列 3篇

BAT AI面试1000题系列 3篇 -

海量数据处理 5篇

海量数据处理 5篇 -

十五大经典算法研究 42篇

十五大经典算法研究 42篇 -

经典树结构:红黑树 B树等 13篇

经典树结构:红黑树 B树等 13篇 -

AI应用:CV NLP 推荐 9篇

AI应用:CV NLP 推荐 9篇 -

技术架构与源码剖析 7篇

技术架构与源码剖析 7篇

TA关注的专栏 0

TA关注的收藏夹 0

TA关注的社区 2

TA参与的活动 0

July,于2010年10月11日开始在CSDN上写博(搜索:结构之法,进入本博客),2015年创办「七月在线」(julyedu.com),一开始做AI技能教育,后24年起侧重:具身智能的场景落地与定制开发,客户所属行业包括但不限于:电力/化工、家电制造/车企/纺织厂、高校等等..

- 1 长沙具身团队:侧重大模型赋能具身的定制开发,例如机械臂上的精密插拔、智能装配,及人形展厅讲解、人形灵巧操作(变电柜/拧阀门)、人形搬运(含轮式和双足)、具身加油机器人(轮式人形)等,PS,一直在扩招985/211的硕士实习生

- 2 武汉具身团队:侧重指导客户对世界级前沿模型的科研与复现,比如ACT/openpi/GR00T

- 3 上海具身团队(原南京团队,后迁至上海):侧重人形机器人大小脑的统一协调开发,偏本体的设计与研究

- 4 北京教育团队:侧重C端服务(如论文、项目、申博等1V1辅导),以及B端企业服务与高校合作

AI 镜像开发实战征文活动

随着人工智能技术的飞速发展,AI 镜像开发逐渐成为技术领域的热点之一。Stable Diffusion 3.5 FP8 作为强大的文生图模型,为开发者提供了更高效的图像生成解决方案。为了推动 AI 镜像开发技术的交流与创新,我们特此发起本次征文活动,诚邀广大开发者分享在 Stable Diffusion 3.5 FP8 文生图方向的实战经验和创新应用 本次征文活动鼓励开发者围绕 Stable Diffusion 3.5 FP8 文生图方向,分享以下方面的内容: 1. 技术实践与优化 - Stable Diffusion 3.5 FP8 模型架构解析与优化技巧 - 文生图生成效果的提升方法与技巧 - 模型部署与加速策略,例如使用 Hugging Face、Diffusers 等工具 - 针对特定场景(例如二次元、写实风)的模型微调与定制化开发 2. 应用场景探索 - Stable Diffusion 3.5 FP8 在不同领域的应用案例分享,例如游戏设计、广告创意、艺术创作等 - 利用 Stable Diffusion 3.5 FP8 实现图像编辑、图像修复、图像增强等功能的探索 - 结合其他 AI 技术(例如 NLP、语音识别)构建更强大的应用 3. 创新应用与思考 - 基于 Stable Diffusion 3.5 FP8 的创新应用场景设计 - AI 镜像开发的未来发展方向的思考与展望 - 对 AI 镜像开发伦理、安全等问题的探讨

- 最近

- 文章

- 专栏

- 视频

- 关注/订阅/互动

- 帖子

- 资源

最近

文章

专栏

视频

关注/订阅/互动

帖子

资源